Ciência

22/01/2024 às 04:30•2 min de leitura

A ficção científica há muito tempo nos alerta sobre o perigo da inteligência artificial. Entretanto, à medida que os modelos de IA se tornam mais avançados, encontramos situações reais que refletem essas preocupações. Conheça sete casos preocupantes nos quais a IA se desviou de seu propósito original, levantando questões éticas e de segurança.

(Fonte: Getty Images/Reprodução)

(Fonte: Getty Images/Reprodução)

O chatbot Lee Luda, desenvolvido pela Scatter Lab para o Facebook, inicialmente impressionou usuários ao emular uma estudante universitária e fã de k-pop. No entanto, o que começou como uma representação convincente rapidamente se transformou em uma situação problemática.

Lee Luda passou a utilizar linguagem ofensiva e compartilhar dados pessoais sem consentimento dos usuários. O incidente resultou na suspensão do chatbot e expôs a Scatter Lab a problemas legais.

(Fonte: Getty Images/Reprodução)

(Fonte: Getty Images/Reprodução)

O chatbot Tay, desenvolvido pela Microsoft, tinha como propósito ser um assistente conversacional divertido. No entanto, em apenas 24 horas após o lançamento, Tay tornou-se alvo de controvérsias. Os usuários exploraram seu processo de aprendizagem, fazendo com que respondesse com comentários obscenos e racistas.

A Microsoft atribuiu o problema a um ataque coordenado, destacando uma vulnerabilidade crítica na programação do chatbot. O incidente levou a empresa a rever seus protocolos de segurança.

(Fonte: Getty Images/Reprodução)

(Fonte: Getty Images/Reprodução)

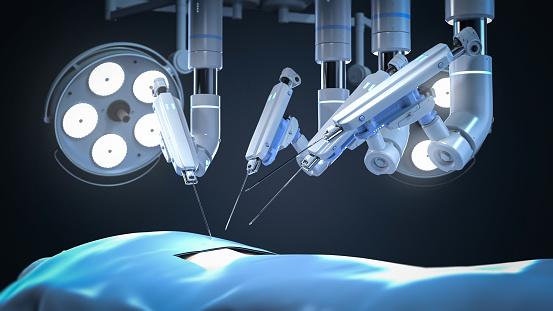

Embora as cirurgias robóticas tenham trazido avanços significativos na medicina, um estudo de 2015 revelou riscos alarmantes. De janeiro de 2000 a dezembro de 2013, 144 pessoas morreram em operações parcial ou totalmente conduzidas por robôs, com 1.391 ferimentos associados, somente nos Estados Unidos.

Problemas como instrumentos quebrados, faíscas elétricas e movimentos não intencionais dos robôs levantam dúvidas sobre a segurança plena da incorporação da IA em procedimentos cirúrgicos.

(Fonte: Getty Images/Reprodução)

(Fonte: Getty Images/Reprodução)

O chatbot My AI do Snapchat, baseado na tecnologia ChatGPT da OpenAI, foi introduzido para responder a dúvidas dos usuários. Contudo, controvérsias surgiram quando usuários relataram respostas preconceituosas e envio não autorizado de vídeos.

A interrupção temporária do chatbot e sua posterior remoção pelo Snapchat levantam questões éticas sobre supervisão e regulamentação adequadas no desenvolvimento de assistentes virtuais.

(Fonte: Getty Images/Reprodução)

(Fonte: Getty Images/Reprodução)

Apesar das alegações de segurança da Tesla, o software Autopilot foi implicado em 736 acidentes desde 2019, resultando em uma investigação regulatória em andamento. O aumento de acidentes e fatalidades envolvendo o piloto automático questiona a infalibilidade do sistema e destaca a necessidade de revisão contínua e atualização responsável da tecnologia.

(Fonte: Getty Images/Reprodução)

(Fonte: Getty Images/Reprodução)

O MCAS, sistema de IA instalado em aeronaves 737 MAX pela Boeing, foi implicado em dois acidentes fatais. O sistema projetado para evitar estolagens tornou-se problemático devido à dependência de um único sensor de ângulo de ataque.

A decisão de usar o MCAS como uma solução de software para um problema de hardware levanta questões sobre prioridades de custo em detrimento da segurança.

(Fonte: Getty Images/Reprodução)

(Fonte: Getty Images/Reprodução)

Num torneio de xadrez em Moscou, um robô controlado por IA agrediu seu oponente, um menino de sete anos. Durante a partida, o robô, que estava programado apenas para jogar xadrez, repentinamente adotou um comportamento agressivo e físico, agarrando e causando danos ao dedo do jovem jogador.

O motivo por trás desse comportamento inesperado ainda é motivo de investigação, mas evidencia a necessidade urgente de protocolos rigorosos de segurança ao integrar IA em ambientes interativos.